-

데이터마이닝 수업 정리기타 2022. 9. 29. 12:55반응형

1. 데이터마이닝이란

p9

p? 지도학습 비지도학습

p21, 30 train/validation/test & overfitting

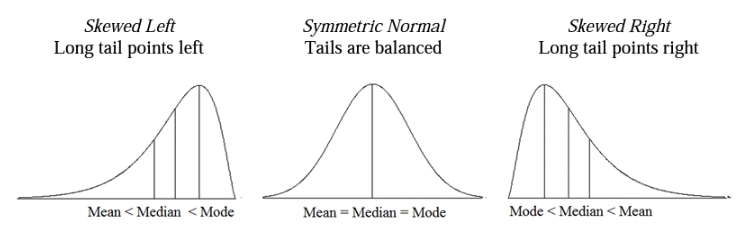

p ?? skew, median, mean, mode

mean : 평균

median : 중위값

mode : 최빈값

skewness : 비대칭도, 왜도

평균 중위 최빈값으로 좌우 왜도를 구분할 수 있나

p 85 중심극한정리(Confidence interval)

동일한 확률분포를 가진 독립 확률 변수 n개의 평균의 분포는 n이 적당히 크다면 정규분포에 가까워진다는 정리

6.confidence interval

p85p109 정규분포(z-score) & t분포(t-score)

- 샘플의 크기가 30보다 큰지?

- 모집단의 표준편차를 아는지?

P 161 데이터의 종류

https://csshark.tistory.com/100

p? 데이터 정규화(Data Normalization, Scaling) & 데이터 변환(Data Transformation)

정규화 : 모든 변수의 단위를 동일한 기준(스케일)로 통일

변환 : 데이터의 분포를 정규분포에 근사하게 변환

P? 상관계수Covariance and correlation

공분산(Covariance)

각 확률변수들이 어떻게 퍼져있는지를 나타내는 것.

두 변수가 독립적이면 공분산이 0이 되지만, 공분산이 0이라고 두 변수가 독립적이라고 확정지을수는 없다.

공분산은 데이터의 스케일에 영향을 받는다.

상관계수(Correlation)

-1 ~ 1 사이의 값을 가지며, 데이터의 스케일에 영향을 받지 않는다.

음수는 음의 상관관계, 양수는 양의 상관관계를 가진다고 볼 수 있다.

두 변수가 독립적이면 상관계수가 0이 되지만, 상관계수가 0이라고 두 변수가 독립적이라고 확정지을수는 없다.

p332 EDA

내용읽기

박스플롯

p371,386 Dimension Reduction, PCA

https://darkpgmr.tistory.com/110

차원감소 = 계산량 감소

p? 귀무/대립 가설, 유의수준

귀무가설 : 틀리길 바라는 조건

대립가설 : 내가 맞기를 바라는 조건

귀무가설에 대해서 검증을 한다!

유의확률 : 높을수록 해당 의견이 맞다!!

그런데 우리는 귀무가설이 틀려야한다! => 즉, 유의확률이 낮게 나와야한다!!!

통상적으로 0.05이상일 경우 의견을 채택하므로,

귀무가설의 유의 확률이 0.05미만일경우 기각하여 대립가설을 채택한다.

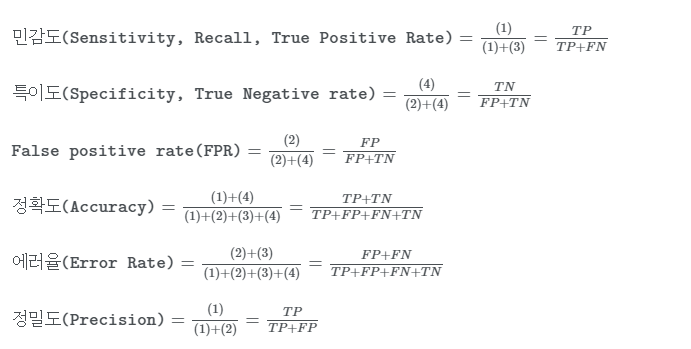

p?? 혼동행렬 (confusion matrix)

p453 : roc, lift curve

roc curve

x축 : true positive(예측yes, 실제 false)

y축 : false positive(예측yes, 실제 yes)

cumulative gains

lisft chart : https://carrot-woo.tistory.com/55

https://todayisbetterthanyesterday.tistory.com/5

p ? 클러스터링

https://csshark.tistory.com/109

ㅇ

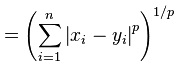

p ? 거리계산 Distance

유클리디안 거리(L2)

https://hleecaster.com/ml-distance-formula/ 멘하탄 거리(L1)

https://hleecaster.com/ml-distance-formula/ 민코우스키 거리(Minkowski Distance)

앞선 거리들을 일반화 하여 사용하는 기법

p = 1 : 멘하탄 거리

p = 2 : 유클리디안 거리

p = 무한대 : 아래 식

마할라노비스 거리(Mahalanobis Distance)

마할라노비스 거리는 데이터 밀도를 고려한 거리

검은색 점와 타원 경계의 점들 사이의 마할라노비스 거리는 같다

p ? Regression with regularization

회귀계수가 가질 수 있는 값에 제약조건을 부여하는 방법

variance를 감소시켜 일반화 성능을 높임 (이 때, bias가 증가)

릿지회귀 => L2

라쏘회귀 => L1

https://ratsgo.github.io/machine%20learning/2017/05/22/RLR/

p ? ANN

p ? Naive Bayes Classifier

exact bayes로 계산할 수 있으나

차원이 높아질 수록 해당 조건에 대한 데이터가 없을 확률이 높고 편향된 데이터가 발생 할 수 있음

따라서, naive bayes로 계산하여 이를 해결

p ? Association rules

https://csshark.tistory.com/108

반응형

반응형'기타' 카테고리의 다른 글

머신러닝 수업 참고자료 리스트 (0) 2022.11.08 인공지능 기초 이론시험 요점 (1) 2022.10.20 [파이썬/자료형]딕셔너리(Dictionary) (0) 2022.09.07 수업 요점정리 2주차(1) (0) 2022.09.06 제조업에서의 AI 혁신, 등대공장(Lighthouse Factory)이란? (0) 2022.08.06